Технологии и ИИ

Федор Жилкин

4 мар. 2025 г.

В мае 2024 года OpenAI представила GPT-4o – свою самую продвинутую на сегодняшний день AI-модель. Буква «o» означает «omni», что подчёркивает революционную возможность модели одновременно обрабатывать текст, изображения, аудио и видео. В отличие от предыдущих моделей, которым для разных типов медиа требовались отдельные системы, GPT-4o всё обрабатывает в единой нейронной сети, что значительно ускоряет работу и расширяет возможности.

Благодаря способности отвечать на голосовые запросы за 320 миллисекунд (почти как у человека), GPT-4o совершает огромный скачок в области взаимодействия человека с AI. В этой статье подробно рассказывается о возможностях новой модели, сравнении с другими AI-решениями и о том, как начать её использовать.

Что такое GPT-4o?

GPT-4o – это флагманская мультимодальная модель от OpenAI, выпущенная в мае 2024 года. Она основана на GPT-4, но дополнена поддержкой обработки сразу нескольких видов данных: текста, изображений, аудио и видео. Буква «o» символизирует универсальность модели, которая теперь не требует разделения задач на разные специализированные системы.

Основные преимущества модели:

Практически мгновенные ответы для голосовых разговоров.

Лучшее понимание контекста при работе с разными типами медиа.

Более естественное общение между человеком и AI.

Улучшенная работа с неанглоязычными текстами.

Значительно повышенная скорость обработки данных.

OpenAI описывает GPT-4o как шаг к более естественному взаимодействию между человеком и компьютером, благодаря почти человеческой скорости ответа.

Сравнение GPT-4o с предыдущими моделями

Чтобы понять значимость GPT-4o, полезно сравнить её с предыдущими моделями из семейства GPT-4.

Feature | GPT-4o | GPT-4 Turbo | Original GPT-4 |

|---|---|---|---|

Release Date | May 2024 | November 2023 | March 2023 |

Multimodal Capabilities | Native text, audio, images, video | Text and images only | Text only (initially) |

Response Speed | 2-3x faster | Standard | Standard |

Audio Response Time | ~320ms | 5.4 seconds (with Voice Mode) | Not available natively |

Cost (API) | $5/$15 per million tokens | $10/$30 per million tokens | $10/$30 per million tokens |

Context Window | 128,000 tokens | 128,000 tokens | 8,192 tokens (initially) |

Non-English Efficiency | Up to 4.4x better tokenization | Standard | Standard |

Knowledge Cutoff | October 2023 | April 2023 | September 2021 |

Основные преимущества GPT-4o:

Ускорение работы: Модель обрабатывает примерно 110 токенов в секунду, что делает ответы в 2–3 раза быстрее, чем у GPT-4 Turbo.

Экономия средств: Стоимость использования GPT-4o составляет 50% от цены GPT-4 Turbo.

Мультимодальная интеграция: Теперь аудио обрабатывается вместе с текстом и изображениями, что раньше требовало отдельных моделей.

Голосовой отклик: Вместо 5,4 секунд для голосового ответа, GPT-4o отвечает примерно за 320 миллисекунд – в 16 раз быстрее.

Эффективная работа с языками: Улучшенная токенизация позволяет экономить токены для языков, таких как гуджарати или телугу (до 4,4x и 3,5x меньше токенов соответственно).

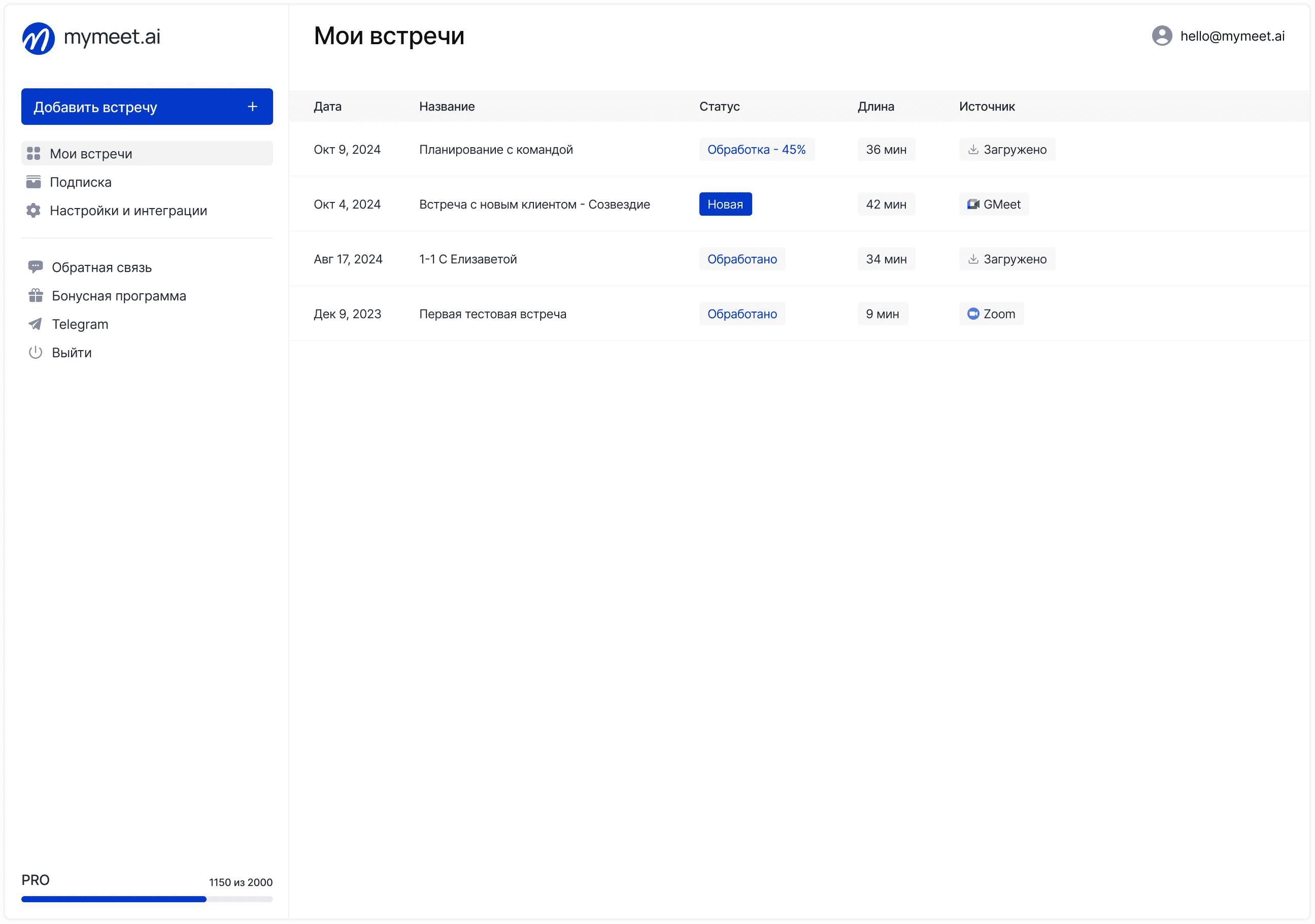

Совместное использование GPT-4o и mymeet.ai для интеллектуальных встреч

Хотя GPT-4o обладает впечатляющими возможностями для работы с текстом, аудио и изображениями, сама по себе модель не может присоединяться к встречам. Здесь на помощь приходит mymeet.ai – специализированный AI-помощник для встреч, который автоматически записывает, транскрибирует и анализирует виртуальные совещания.

Как работает интеграция:

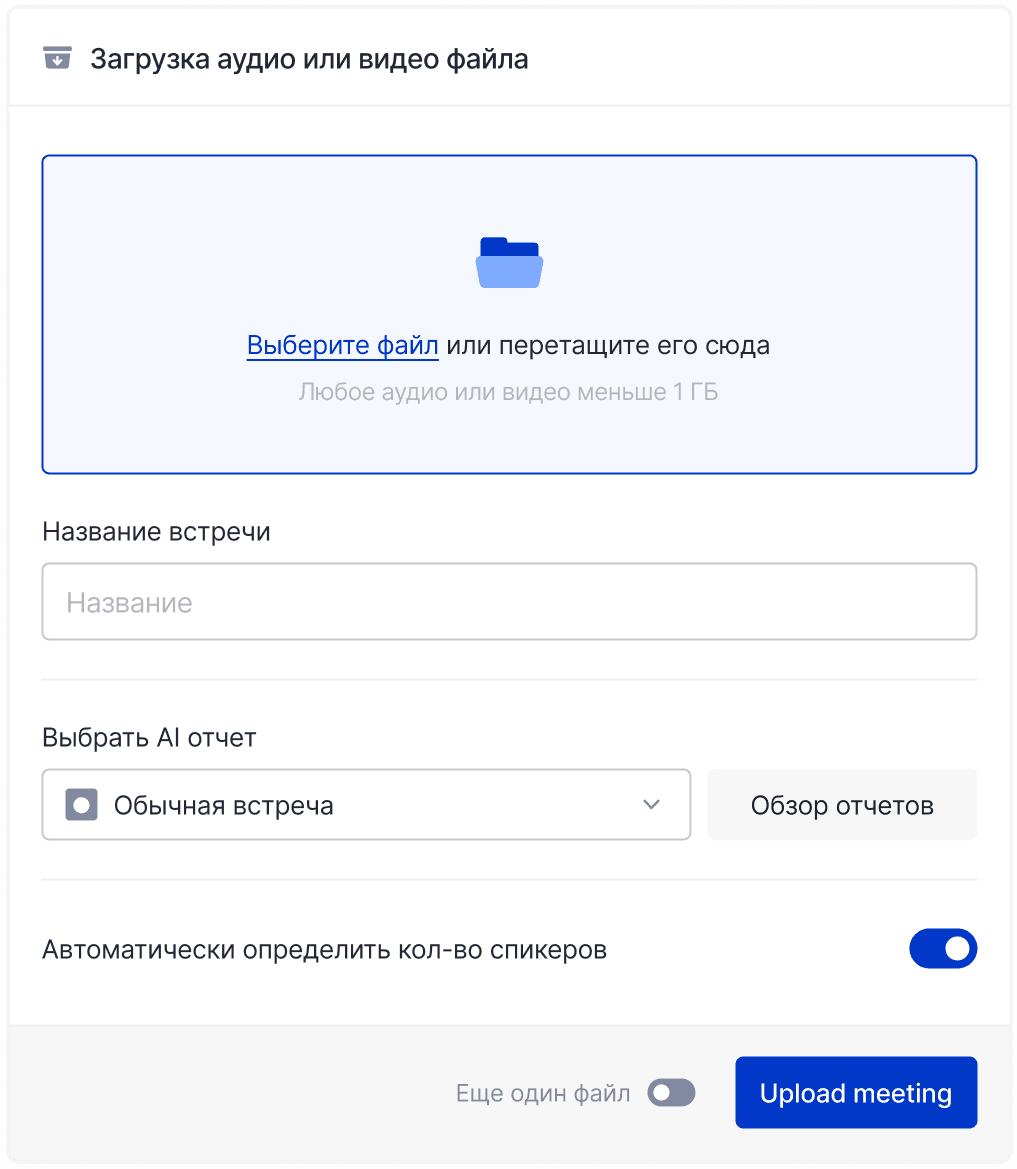

Автоматическая запись встреч: mymeet.ai подключается к запланированным встречам через календарь и записывает всё, что происходит.

Интеллектуальная транскрипция: Все разговоры транскрибируются с идентификацией говорящих на 73 языках.

Первичный анализ: mymeet.ai автоматически выделяет задачи и составляет базовые резюме.

Углублённая обработка GPT-4o: Экспортируйте содержимое встречи в GPT-4o для более детального анализа:

Полные сводки встреч с использованием возможностей логического анализа GPT-4o.

Генерация кода по техническим обсуждениям (с помощью модели o3-mini-high).

Решение сложных задач с использованием модели o1.

Визуальный анализ демонстраций и презентаций.

Примеры применения:

Для разработчиков: Команды фиксируют технические обсуждения и затем используют GPT-4o для преобразования требований в планы реализации.

Для отделов продаж: Запись встреч с клиентами, анализ возражений и разработка персонализированных стратегий последующих действий.

Для анализа данных и исследований: Сочетание транскрипций встреч и анализа диаграмм для извлечения полезных бизнес-инсайтов.

Линейка моделей OpenAI: GPT-4o, o1, o3-mini и другие

OpenAI предлагает несколько специализированных моделей для различных задач:

GPT-4o (флагманская модель): Универсальная модель для работы с текстом, изображениями, аудио и видео.

GPT-4o с отложенными задачами (бета): Позволяет планировать ответы на будущее (например, напоминания или отсроченное выполнение задач).

o1: Специализированная модель для глубокого логического анализа, идеальна для сложных математических и научных задач.

o3-mini: Модель для быстрого ответа, подходит для простых запросов и реального времени.

o3-mini-high: Модель для программирования, генерирует и отлаживает код, а также помогает с технической документацией.

Когда использовать каждую модель:

GPT-4o: Для задач, где нужно работать с разными типами данных (текст, изображения, аудио).

GPT-4o с отложенными задачами: Для создания напоминаний и планирования ответов.

o1: При решении сложных логических и математических задач.

o3-mini: Для быстрых запросов и в приложениях, где важна скорость.

o3-mini-high: Для программирования и технических задач.

Ключевые особенности GPT-4o

Самая заметная особенность GPT-4o – это возможность вести голосовые беседы практически в реальном времени. Раньше для голосового общения использовался сложный набор моделей: сначала распознавание речи, затем обработка текста, а потом синтез речи. Теперь всё это происходит в единой нейронной сети, что позволяет отвечать за 320 миллисекунд – почти как у человека (примерно 210 мс).

Мультимодальное понимание

GPT-4o без труда обрабатывает:

Текст: Показывает высокое качество работы с английским языком и значительно улучшает результаты для неанглоязычных текстов.

Изображения: Анализирует фотографии, диаграммы, схемы и даже рукописный текст.

Аудио: Понимает интонацию, акценты, идентифицирует нескольких говорящих и учитывает фоновые звуки.

Видео: Хотя функция ещё развивается, GPT-4o уже способен анализировать как визуальные, так и звуковые компоненты видеоматериалов.

Улучшенная токенизация для мировых языков

Модель значительно эффективнее обрабатывает тексты на языках, использующих нелатинские алфавиты. Например, для гуджарати, телугу, тамильского и других языков количество токенов сокращается в несколько раз, что снижает стоимость и повышает точность при работе с международным контентом.

Голосовые и аудио возможности

GPT-4o умеет распознавать эмоциональные нюансы в голосе, что позволяет системе точнее интерпретировать контекст разговора и намерения говорящего. Технология эффективно обрабатывает речь даже при наличии фонового шума или когда в разговоре участвуют несколько человек одновременно.

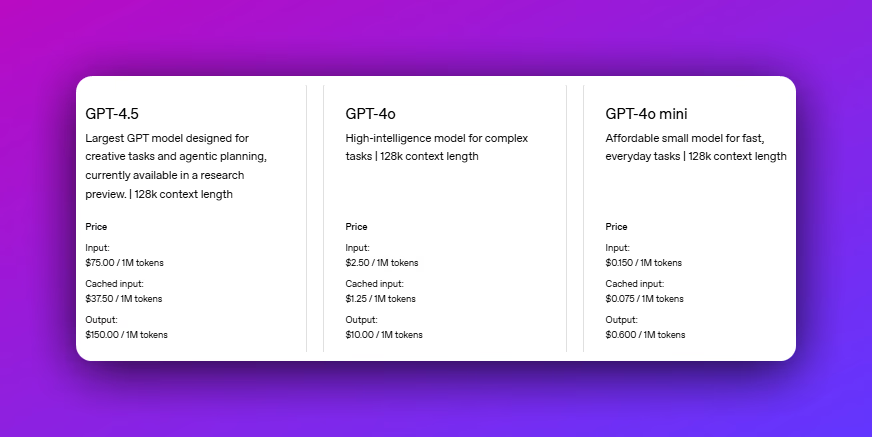

GPT-4o mini: компактная альтернатива

Помимо основной модели, OpenAI представила GPT-4o mini – меньшую, более быструю и экономичную модель, которая заменяет GPT-3.5 Turbo для бесплатных пользователей. Она поддерживает мультимодальные возможности (текст и изображения, аудио в разработке) и стоит всего 60% от цены GPT-3.5 Turbo.

Когда использовать ту или иную модель OpenAI

Выбор подходящей модели искусственного интеллекта от OpenAI может существенно повлиять на эффективность решения задач и оптимизацию ресурсов. Понимание сильных сторон каждой модели позволяет максимально использовать их потенциал в различных сценариях.

GPT-4o

Оптимальный выбор, когда требуется обрабатывать несколько типов данных одновременно — текст, изображения и аудио. Эта сбалансированная модель отлично справляется с разнообразными задачами благодаря мультимодальным возможностям.

GPT-4o с отложенными задачами

Идеально подходит для ситуаций, где необходимо планирование действий во времени. Позволяет задавать напоминания или программировать автоматические ответы на определенное время в будущем.

Модель o1

Следует выбирать для работы со сложными логическими и математическими задачами, где критически важна высокая точность вычислений и рассуждений. Специализированная модель для аналитических задач.

Модель o3-mini

Наилучший вариант, когда на первый план выходит скорость обработки. Эффективно справляется с простыми запросами в реальном времени, обеспечивая мгновенную реакцию системы.

Модель o3-mini-high

Специализированное решение для задач программирования. Демонстрирует отличные результаты при генерации и отладке кода различной сложности.

Для достижения оптимальной производительности и рационального использования ресурсов важно стратегически подходить к выбору модели, учитывая конкретные требования каждой задачи.

Тестирование и производительность GPT-4o

OpenAI провела серию тестов, которые показали, что GPT-4o демонстрирует отличные результаты по различным метрикам:

Benchmark | GPT-4o | GPT-4 Turbo | Claude 3 Opus | Gemini 1.5 Pro |

|---|---|---|---|---|

MMLU (%) | 88.7 | 86.5 | 86.8 | 81.9 |

GPQA (%) | 53.6 | 48.0 | 50.4 | N/A |

MATH (%) | 76.6 | 72.6 | 60.1 | 58.5 |

HumanEval (%) | 90.2 | 87.1 | 84.9 | 71.9 |

MGSM (%) | 90.5 | 88.5 | 90.7 | 88.7 |

Понимание текста и логика: GPT-4o стабильно превосходит GPT-4 Turbo по тестам MMLU, GPQA, MATH и HumanEval.

Мультиязычность: Модель показывает значительный прирост качества при работе с языками, такими как китайский, португальский, тайский и вьетнамский.

Аудио транскрипция и перевод: Результаты сравнимы с специализированными моделями, такими как Whisper v3.

Визуальное восприятие: GPT-4o успешно справляется с интерпретацией диаграмм, извлечением текста из изображений и решением визуальных задач.

В тестах видно, что GPT-4o – значительный шаг вперёд по сравнению с предыдущими моделями, особенно благодаря возможности работать с различными типами данных в единой модели.

Способы доступа к GPT-4o

GPT-4o доступен через различные каналы, в зависимости от ваших потребностей и бюджета:

Бесплатный доступ

Бесплатные пользователи ChatGPT могут использовать GPT-4o для работы с текстом и изображениями, однако имеются ограничения:

Ограниченное количество сообщений в день.

При достижении лимита система переходит на GPT-4o mini.

Некоторые функции, например голосовые, могут быть недоступны.

Подписка ChatGPT 4o Plus ($20/месяц)

Пользователи Plus получают:

В 5 раз большее количество сообщений.

Приоритетный доступ в часы пик.

Полный набор функций, включая голосовые возможности.

Возможность переключаться между моделями (GPT-4o, o1, o3-mini, o3-mini-high).

Доступ к функции отложенных задач (бета).

Подписка ChatGPT 4o Pro ($200/месяц)

Премиум-подписка для профессиональных пользователей с:

Безлимитным использованием всех моделей.

Отсутствием ограничений и замедлений.

Высоким приоритетом в часы пиковых нагрузок.

Расширенными возможностями анализа данных и генерации более длинного контента.

Доступ через API

Разработчики могут интегрировать GPT-4o через API:

Стоимость ввода: $5 за миллион токенов (на 50% дешевле GPT-4 Turbo).

Стоимость вывода: $15 за миллион токенов.

Ограничения скорости увеличены в 5 раз.

Быстрее отклик в 2 раза по сравнению с GPT-4 Turbo.

Для менее требовательных задач доступна модель GPT-4o mini по ещё более низким тарифам.

Десктоп и мобильные приложения

OpenAI расширяет доступ к GPT-4o через:

Десктоп-приложения: Для macOS (Windows скоро появится) с возможностью захвата экрана для визуального анализа.

Мобильные приложения: Официальные приложения для iOS и Android, включающие голосовые возможности и интеграцию с камерой.

Применение GPT-4o в реальном мире

GPT-4o находит применение в различных сферах:

OpenAI в разработке ПО

GPT-4o переводит описания на естественном языке в функциональный код, анализирует код через скриншоты или текст для поиска ошибок, автоматически создает подробную документацию и помогает в проектировании систем и структур баз данных.

GPT в создании контента

Технология демонстрирует высокую эффективность при разработке многоязычных материалов, извлечении информации из диаграмм, графиков и изображений, создании иллюстраций по текстовому описанию и преобразовании речи в текст с последующим резюмированием.

ChatGPT в образовании и исследованиях

Образование получает значительные преимущества благодаря возможностям интерактивного обучения с адаптивными диалогами и мгновенной обратной связью, комбинированному использованию текста, изображений и голоса для разъяснения сложных концепций, а также обработке исследований, визуализаций и экспериментальных результатов.

GPT-4o в бизнесе

В бизнес-среде GPT-4o применяется для создания голосовых чат-ботов, способных анализировать изображения товаров и помогать клиентам, извлечения инсайтов из графиков и визуальных данных, автоматической транскрипции встреч с резюмированием и выделением задач в режиме реального времени, а также для планирования последующих действий через систему отложенных задач и автоматических напоминаний.

Ограничения GPT-4o

Несмотря на все достоинства, у GPT-4o есть и ограничения:

Знания: Данные для обучения заканчиваются октябрем 2023 года, поэтому события после этого периода не известны, если не используется веб-браузинг.

Галлюцинации: Как и все большие модели, GPT-4o иногда генерирует неверную информацию.

Сложные вычисления: Модель всё ещё может ошибаться при выполнении сложных математических расчётов; для таких задач лучше использовать модель o1.

Контекст: Даже при окне в 128 000 токенов GPT-4o может забывать детали очень длинных документов или бесед.

Конфиденциальность: Сессии могут сохраняться OpenAI для улучшения модели, если пользователь не откажется от этого.

Безопасность: Некоторые темы могут быть ограничены мерами безопасности, что может мешать легитимному использованию.

Акценты и диалекты: Модель может испытывать трудности с сильными акцентами или региональными особенностями речи.

Будущее GPT-4o и дальнейшие планы OpenAI

OpenAI не собирается останавливаться на достигнутом. Компания планирует существенно улучшить голосовые функции, добавив возможность прерывания речи и расширив выбор доступных голосов. В ближайшей перспективе также обещают полную поддержку видео — система сможет анализировать видеопоток в реальном времени и взаимодействовать с ним.

Разработчики анонсировали расширенный контроль API для более точной настройки мультимодальной генерации и усовершенствование мер безопасности, направленных на снижение ложных срабатываний. Особое внимание уделяется созданию кастомизированных помощников, адаптированных под различные отрасли.

Аналитики сходятся во мнении, что GPT-4o — это только начало новой эры искусственного интеллекта. В этой эпохе границы между различными типами медиа постепенно размываются, а грань между человеком и машиной становится всё менее заметной.

Советы по эффективному использованию GPT-4o

Чтобы получить максимум от GPT-4o, рекомендуется:

Мультимодальное задание: Комбинируйте текст, изображения и голос для более комплексных ответов (например, покажите график и задайте вопрос о трендах).

Переключение моделей: Используйте o1 для сложных рассуждений, o3-mini для задач, где важна скорость, и o3-mini-high для программирования.

Оптимизация голоса: Говорите чётко, используйте естественную речь, чтобы модель лучше понимала контекст.

Детализированные запросы: Формулируйте конкретные инструкции (например, «Напиши статью на 1000 слов о тенденциях возобновляемой энергетики для технической аудитории с акцентом на новейшие инновации в хранении солнечной энергии»).

Итеративное уточнение: Запрашивайте доработки и уточнения, чтобы ответ максимально соответствовал вашим требованиям.

Оптимизация затрат для разработчиков: Сократите количество токенов в запросах, кэшируйте часто используемые ответы и подбирайте наиболее эффективную модель для каждой задачи.

Визуальное задание: При работе с изображениями указывайте, на какие элементы следует обратить внимание (например, «Обрати внимание на диаграмму в правом верхнем углу и опиши наблюдаемый тренд»).

Заключение

GPT-4o – это настоящий прорыв в технологиях AI, объединяющий обработку текста, изображений, аудио и видео в одной модели. Благодаря почти человеческой скорости голосовых ответов, улучшенной мультиязычной поддержке и единому подходу к мультимодальному пониманию, GPT-4o задаёт новый стандарт для AI-помощников.

Для обычных пользователей GPT-4o делает общение с AI более естественным, а для разработчиков и бизнеса открывает новые возможности для создания приложений, объединяющих несколько типов данных в одном решении. Несмотря на существующие ограничения, GPT-4o уже сегодня демонстрирует огромный потенциал, а дальнейшие обновления обещают ещё больше возможностей.

FAQ

Что такое GPT-4o?

GPT-4o – это мультимодальная AI-модель от OpenAI, выпущенная в мае 2024 года, которая способна одновременно обрабатывать текст, изображения, аудио и видео в единой нейронной сети.

Когда была выпущена GPT-4o?

Официальный анонс и выпуск GPT-4o состоялся 13 мая 2024 года в рамках весеннего обновления OpenAI.

Что означает буква «o» в GPT-4o?

Буква «o» означает «omni» – универсальную способность модели работать с различными типами данных.

Можно ли пользоваться GPT-4o бесплатно?

Да, бесплатные пользователи ChatGPT имеют доступ к GPT-4o с ограничениями (ограниченное число сообщений в день, переключение на GPT-4o mini после лимита, некоторые функции могут быть недоступны).

Что такое GPT-4o mini?

GPT-4o mini – это компактная, более быстрая и экономичная версия GPT-4o, заменяющая GPT-3.5 Turbo для бесплатных пользователей и предлагающая мультимодальные возможности.

В чем отличие GPT-4o от GPT-4?

GPT-4o обрабатывает текст, изображения, аудио и видео нативно, работает в 2–3 раза быстрее, стоит на 50% дешевле и имеет улучшенную токенизацию для неанглийских языков. Кроме того, голосовые ответы теперь приходят почти мгновенно.

Может ли GPT-4o получать актуальные данные?

Сами данные обучения GPT-4o заканчиваются октябрем 2023 года, но при использовании в ChatGPT с включённым веб-браузингом модель может получать актуальную информацию.

Какие языки поддерживает GPT-4o?

Модель поддерживает более 50 языков, демонстрируя особенно высокую эффективность при работе с языками, использующими нелатинские алфавиты, такими как гуджарати, телугу, тамильский, хинди, арабский, китайский и японский.

Насколько быстро GPT-4o по сравнению с предыдущими моделями?

GPT-4o обрабатывает текст в 2–3 раза быстрее, а голосовые ответы приходят за 320 миллисекунд вместо 5,4 секунд.

Федор Жилкин

4 мар. 2025 г.